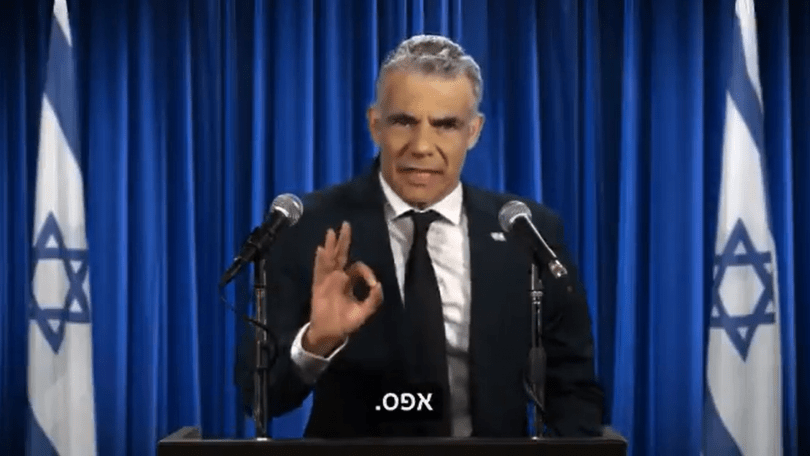

בסרטון בטכנולוגיית Deep Fake נראה יו"ר יש עתיד, יאיר לפיד, "מתייצב מול המצלמות" ומתחייב למנות שני שרים ערבים בכירים. הסרטון קרא לשיתוף פעולה ערבי-יהודי. במוצאי שבת, לפיד אמר בריאיון בתכנית "פגוש את העיתונות" כי יהיה מוכן להקים ממשלה בתמיכה מבחוץ של הרשימה המשותפת, לאחר הבחירות הקרובות במרץ.

בשבועיים האחרונים התגלגל ברשתות החברתיות סרטון בו יו"ר יש עתיד, יאיר לפיד, עמד מול המצלמות והתחייב למנות שני שרים ערבים בכירים, ומציין את העובדה שלא קמו ערים ערביות מאז הקמת המדינה. הבעיה? זה לא באמת יאיר לפיד. כפי שמצוין לכל אורך הקליפ, ובסופו, המציג אינו לפיד, אלא שחקן עליו השתמשו בטכנולוגיית Deep Fake. ע"פ אתר חדשות התעשייה "אייס", דיון סוער התפתח בין המגיבים ברשתות החברתיות לאור העובדה כי הסרטון נחתם ביוזמת "האם ראית את האופק לאחרונה?" בהובלת שיר נוסצקי ורגב קונטס. במוצאי שבת האחרונה, לפיד אף אמר בריאיון לחדשות 12 כי יהיה מוכן להקים ממשלה בתמיכה מבחוץ של הרשימה המשותפת, לאחר הבחירות הקרובות במרץ. אך זהו לא הסרטון היחיד של השבועיים האחרונים של פייק ניוז שעולה מצד משתמשים.

- דעה: הגנץ צריך ללכת, האיזנקוט צריך להחליט

- דעה: בתקופת החשמונאים היה לנו את חוני המעגל, כעת יש לנו את גנץ הפוקק

- האם אישרו, ומי אישר, ליועץ הניו מדיה של ראש הממשלה שימוש בצ'קלקה?

- דעה: הזמן האבוד, או למה חזרנו?

- ראש הישיבה דיבר על מספר אחד, משרד החינוך נתן מספר אחר ובדרך חשף אמת מדאיגה

ביום חמישי שעבר, ראש הממשלה בנימין נתניהו הודיע, יחד עם שר האוצר, ישראל כ"ץ, והזמר אביב גפן על התחייבות מחודשת לתחום התרבות בשווי 70 מיליון שקלים. באתר וואלה ניוז דווח בשבוע שעבר כי נגד המתווה ניחתה ביקורת רבה. חלק מאנשי עולם התרבות אף קראו למתווה "מחורר". בד בבד, החל לעלות סרטון ברשתות החברתיות בו רואים את פרצופו של רה"מ, דרך טכנולוגיית Deep-Fake, שר את המשפט האייקוני של גפן "עכשיו מעונן". נכון לכתיבת שורות אלה, לא ידוע למערכת לתוך הלילה מי או מתי נוצר הסרטון.

אופיר בראל, חוקר תופעת הפייק-ניוז, מסר למגזין לתוך הלילה: "בחינה של סוגי המחקרים שנוהלו בשנים האחרונות מציגה מספר מאפיינים- גילוי סרטוני Deep-fake, כתחום מחקר, החל להתפתח לפני כשלוש שנים, פחות או יותר. העבודה המוקדמת בתחום התמקדה בבחינת מאפיינים ויזואליים של הסרטונים הללו. סוג מחקר זה, למשל, התמקד בעובדה שהדמויות המצולמות בסרטונים הללו לא ממצמצות", ופירט: "בהמשך, הסרטונים המזויפים נהפכו למשוכללים יותר, מה שהצריך פיתוח אמצעים חדשים ומתקדמים יותר".

ע"פ בראל, היום קיימות שתי קטגוריות עיקריות בתחום המחקר. "הראשונה מתמקדת בחקר ההתנהגות של האנשים המצולמים בסרטונים הללו. בגישה הזו, בינה מלאכותית יודעת לנתח את מאפייני ההתנהגות (האמיתיים) של דמות מסוימת- אלו יכולים להיות דפוסי התנהגות שכמעט אינם נראים, כמו תנועות ידיים- ולהשוות אותם לדפוסי ההתנהגות של אותה דמות, שמצולמת מסרטון מזויף" הסביר בראל, והרחיב: "הגישה השנייה מתמקדת בהבדלים הקיימים בכלל סרטוני ה-Deep-fake, בהשוואה לסרטונים אמיתיים. הכיוון המחקרי הזה מתבסס על העובדה, שסרטוני Deep-fake נוצרים על ידי מיזוג פריימים בודדים לסרטון יחיד. צוותי מחקר שפועלים בשיטה הזו, מנתחים את המידע הקיים בכל פריים בודד ומוצאים אם ישנם הבדלים או סתירות בין פריים אחד למשנהו. לעיתים, ניתן להשתמש בשיטת המחקר הזו גם על מנת לנתח קטעי אודיו מזויפים".

בהתייחס לסרטונים על רה"מ, בראל ציין כי נעשו ניסיונות בעבר, אך לא במהלך מערכת בחירות פעילה. "גם על ליברמן (יו"ר ישראל ביתנו אביגדור ליברמן- א"ו) עשו אבל זה היה במסגרת תוכנית בידור" אמר בראל.